Die nächste Generation der Kundenkommunikation: Ragbot setzt auf die RAG-Technologie

Erfahren Sie, wie durch fortschrittliche Informationssuche und Textgenerierung das Kundenerlebnis revolutioniert wird

Was ist die RAG-Technologie?

Die RAG-Technologie, auch bekannt als Retrieval-Augmented Generation, ist ein bedeutender Fortschritt in der Entwicklung von Chatbots und der Verarbeitung natürlicher Sprache. Herkömmliche Chatbots basierten auf vorab definierten Antworten, was sie oft starr und eingeschränkt machte. Im Gegensatz dazu ermöglicht RAG die dynamische Suche nach Informationen aus verschiedenen Datenquellen in Echtzeit. Das bedeutet, dass ein Chatbot mit RAG-Technologie nicht nur vorgefertigte Antworten liefert, sondern auch relevante Informationen aus unterschiedlichen Quellen sammelt und kontextbezogene Antworten generiert.

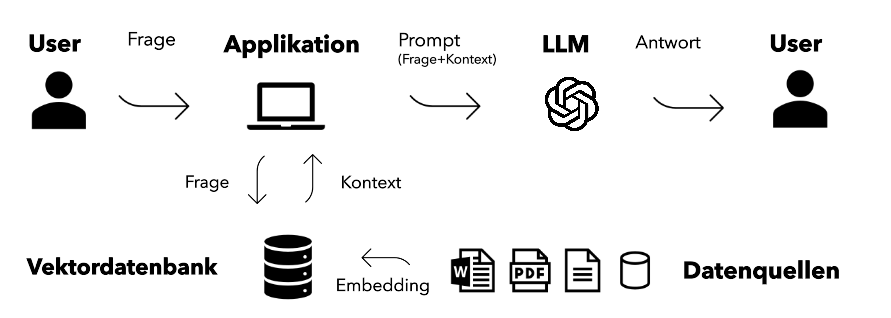

Wie funktioniert die RAG-Technologie?

1. Datengrundlage

Die RAG-Technologie greift auf eine Vielzahl von Datenquellen zurück, die sowohl interne als auch externe Informationen umfassen.

Interne Quellen: Dies können Kundendatenbanken, Produktinformationen und Servicehistorien sein. Beispielsweise könnte ein Chatbot auf die spezifischen Bestellhistorien eines Kunden zugreifen, um eine detaillierte und personalisierte Antwort zu geben. Wenn ein Kunde fragt: „Wann wurde meine letzte Bestellung geliefert?“, kann der Chatbot diese Information direkt aus der internen Datenbank abrufen.

Externe Quellen: Dazu gehören Online-Rezensionen, Forenbeiträge und soziale Medien. Diese Quellen bieten zusätzliche Perspektiven und ermöglichen dem Chatbot, umfassendere Antworten zu geben. Zum Beispiel könnte ein Kunde fragen: „Was sagen andere Benutzer über das Produkt X?“ Der Chatbot kann aktuelle Bewertungen und Diskussionen aus verschiedenen Online-Foren und Bewertungsportalen heranziehen, um eine fundierte Antwort zu geben.

2. Vektor-Datenbank und Embedder

Die Vektor-Datenbank und der Embedder sind zentrale Komponenten der RAG-Technologie.

Vektor-Datenbank: Diese speichert Informationen in einem mehrdimensionalen Raum, sodass ähnliche Datenpunkte nah beieinander liegen. Dies erleichtert die Suche nach relevanten Informationen. Stellen Sie sich vor, Sie haben eine Bibliothek, in der Bücher nach Themen sortiert und nah beieinander aufgestellt sind. So finden Sie schneller verwandte Bücher.

Embedder: Der Embedder wandelt Textdaten in Vektoren um und berücksichtigt dabei komplexe Beziehungen zwischen Wörtern und Sätzen. Diese Transformation ist wie das Übersetzen von Text in eine mathematische Form, die von Computern leichter verarbeitet werden kann. Beispielsweise könnte der Satz „Katzen sind großartige Haustiere“ als Vektor dargestellt werden, der die Beziehung und Bedeutung der Wörter berücksichtigt. Dadurch kann der Chatbot schneller relevante Informationen finden, wenn ein Benutzer nach Informationen zu Haustieren fragt.

3. Retrieval-Komponente

Die Retrieval-Komponente ist das Herzstück der RAG-Technologie. Sie verwendet fortschrittliche Suchalgorithmen und maschinelles Lernen, um relevante Informationen aus der Vektor-Datenbank zu extrahieren.

Wie funktioniert die Retrieval-Komponente in der RAG-Technologie?

Analyse der Benutzeranfrage: Wenn ein Benutzer eine Anfrage stellt, analysiert die Retrieval-Komponente diese Anfrage zunächst, um ihre Bedeutung und den Kontext zu verstehen. Dies ist entscheidend, um sicherzustellen, dass die extrahierten Informationen wirklich relevant sind. Zum Beispiel, wenn ein Benutzer fragt: „Wie kann ich mein Passwort zurücksetzen?“, muss die Retrieval-Komponente erkennen, dass die Anfrage sich auf Kontosicherheit und technische Anweisungen bezieht.

Vergleich mit der Vektor-Datenbank: Die analysierte Anfrage wird dann mit den in der Vektor-Datenbank gespeicherten Informationen verglichen. Die Vektor-Datenbank speichert Informationen in Form von Vektoren, die komplexe semantische Beziehungen zwischen Wörtern und Sätzen berücksichtigen. Dies ermöglicht eine schnelle und präzise Suche nach relevanten Informationen. Stellen Sie sich vor, die Vektor-Datenbank sei wie eine riesige Bibliothek, in der Bücher nicht nach Titeln, sondern nach den in ihnen enthaltenen Ideen und Konzepten sortiert sind. Wenn die Anfrage „Passwort zurücksetzen“ eingeht, sucht die Retrieval-Komponente nach allen verwandten Konzepten und Anleitungen in der Datenbank.

Verwendung von Suchalgorithmen und maschinellem Lernen: Die Retrieval-Komponente verwendet fortschrittliche Suchalgorithmen und maschinelle Lerntechniken, um die relevantesten Informationen zu identifizieren. Diese Algorithmen berücksichtigen die semantische Ähnlichkeit und den Kontext der Benutzeranfrage, um die besten Ergebnisse zu liefern. Zum Beispiel könnte die Komponente verschiedene Anleitungen und Tipps zum Zurücksetzen von Passwörtern aus der Datenbank abrufen und diejenige auswählen, die am besten zur spezifischen Anfrage des Benutzers passt.

Extraktion und Aufbereitung der relevanten Informationen: Nachdem die relevantesten Informationen identifiziert wurden, extrahiert die Retrieval-Komponente diese Daten und bereitet sie für die Weiterverarbeitung durch das Sprachmodell vor. Dies bedeutet, dass die Informationen in einem Format präsentiert werden, das das Sprachmodell leicht verarbeiten und in eine natürliche Sprache umwandeln kann. Zum Beispiel könnte die Komponente eine detaillierte Anleitung zum Zurücksetzen des Passworts extrahieren und diese in logische Schritte unterteilen, die das Sprachmodell dann in eine verständliche Anleitung für den Benutzer umwandelt.

Beispiel:

Angenommen, ein Benutzer fragt: „Wie kann ich mein WLAN-Problem beheben?“ Die Retrieval-Komponente würde wie folgt arbeiten:

- Analyse der Anfrage: Die Komponente erkennt, dass es sich um eine technische Supportanfrage handelt, die Lösungen für WLAN-Probleme erfordert.

- Suche in der Vektor-Datenbank: Sie durchsucht die Vektor-Datenbank nach Anleitungen, Tipps und häufig gestellten Fragen zum Thema WLAN-Probleme.

- Datenextraktion: Sie extrahiert die relevantesten Informationen, wie etwa Schritte zur Fehlerbehebung, und bereitet sie auf.

- Weitergabe an das Sprachmodell: Die extrahierten Daten werden an das Sprachmodell übergeben.

- Generierung und Bereitstellung der Antwort: Das Sprachmodell erstellt eine verständliche und detaillierte Antwort, die dem Benutzer hilft, das WLAN-Problem zu beheben.

Durch diesen Prozess stellt die Retrieval-Komponente sicher, dass die RAG-Technologie präzise und relevante Antworten liefert, die auf den spezifischen Bedürfnissen und Kontexten der Benutzeranfragen basieren. Dies verbessert die Effizienz und Zufriedenheit der Kundeninteraktionen erheblich.

4. Das Large Language Model

Ein weiterer zentraler Bestandteil der RAG-Technologie ist die Verwendung fortschrittlicher Sprachmodelle, wie beispielsweise ChatGPT von OpenAI, Llama 3 von Meta oder Mistral von Mistral AI. Diese Modelle sind entscheidend für die Generierung von natürlichen und präzisen Antworten, die auf den von der Retrieval-Komponente bereitgestellten Informationen basieren.

Wie funktionieren diese Sprachmodelle in der RAG-Technologie?

Datenverarbeitung durch das Sprachmodell: Nachdem die Retrieval-Komponente relevante Informationen aus der Vektor-Datenbank extrahiert hat, werden diese Daten an das Sprachmodell weitergeleitet. Das Sprachmodell analysiert diese Daten und verwendet sie, um eine kohärente und sinnvolle Antwort zu generieren. Zum Beispiel, wenn ein Benutzer fragt: „Was sind die Vorteile von Produkt X?“, sammelt die Retrieval-Komponente relevante Informationen aus internen und externen Datenquellen. Das Sprachmodell formt diese Informationen dann zu einer verständlichen Antwort wie: „Produkt X bietet zahlreiche Vorteile, darunter erhöhte Effizienz, Benutzerfreundlichkeit und Kosteneinsparungen.“

Kontextverständnis und Antwortgenerierung: Die Sprachmodelle sind darauf trainiert, den Kontext und die Nuancen der Benutzeranfragen zu verstehen. Dies bedeutet, dass sie nicht nur wortwörtlich auf die Anfrage antworten, sondern auch den Kontext und die Intention des Benutzers berücksichtigen. Wenn ein Benutzer beispielsweise eine vage oder komplexe Frage stellt, kann das Sprachmodell den Kontext erfassen und eine relevante und präzise Antwort liefern. Zum Beispiel, wenn ein Kunde fragt: „Wie kann ich mein Konto wiederherstellen?“, wird das Sprachmodell basierend auf den abgerufenen Informationen eine detaillierte Schritt-für-Schritt-Anleitung zur Kontowiederherstellung generieren.

Personalisierte Antworten: Sprachmodelle können auch personalisierte Antworten liefern, indem sie die spezifischen Bedürfnisse und Präferenzen der Benutzer berücksichtigen. Wenn ein Kunde regelmäßig bestimmte Produkte kauft oder spezifische Serviceanfragen hat, kann das Sprachmodell diese Informationen nutzen, um maßgeschneiderte Empfehlungen oder Lösungen anzubieten. Zum Beispiel, wenn ein Stammkunde nach neuen Angeboten fragt, könnte der Chatbot antworten: „Basierend auf Ihren bisherigen Einkäufen könnte unser neues Produkt Y für Sie interessant sein. Es bietet ähnliche Funktionen wie die Produkte, die Sie häufig kaufen, jedoch mit zusätzlichen Vorteilen.“

Kontinuierliche Verbesserung durch maschinelles Lernen: Die Sprachmodelle werden kontinuierlich mit neuen Daten und Feedback trainiert, was bedeutet, dass sie im Laufe der Zeit immer besser werden. Jedes Mal, wenn ein Benutzer mit dem Chatbot interagiert, sammelt das System Daten darüber, wie gut die Antworten waren und wie der Benutzer reagiert hat. Diese Daten werden verwendet, um das Modell weiter zu verbessern und sicherzustellen, dass zukünftige Antworten noch präziser und hilfreicher sind. Zum Beispiel, wenn viele Benutzer ähnliche Fragen stellen und ähnliche Antworten erhalten, kann das System lernen, diese Antworten zu optimieren und schneller zu liefern.

Integration und Workflow

Der gesamte Prozess von der Datenakquise bis zur Antwortgenerierung kann nahtlos in bestehende Unternehmenssysteme integriert werden. Die verschiedenen Komponenten der RAG-Technologie arbeiten zusammen, um einen reibungslosen Informationsfluss und eine intuitive Benutzererfahrung zu gewährleisten.

Integration in Unternehmenssysteme: Zum Beispiel kann ein RAG-basierter Chatbot in die Kundenservice-Plattform eines Unternehmens integriert werden. Wenn ein Kunde eine Frage stellt, sammelt der Chatbot relevante Informationen aus internen Datenbanken und externen Quellen, verarbeitet diese Informationen und generiert eine präzise Antwort.

Kontinuierliches Lernen und Optimierung: Darüber hinaus lernt und optimiert das System kontinuierlich, um immer bessere Ergebnisse zu liefern. Wenn neue Daten verfügbar werden oder sich die Bedürfnisse der Kunden ändern, passt sich das System automatisch an, um weiterhin genaue und relevante Antworten zu liefern.